Negli ultimi anni l’Intelligenza Artificiale (IA) ha iniziato a farsi strada anche in ambiti tradizionalmente complessi come l’anatomia patologica. In particolare, i Large Language Models (LLMs), come ChatGPT, vengono sempre più impiegati per assistere i medici nella sintesi di informazioni cliniche, nella redazione di referti e nel supporto alle diagnosi. Ma fino a che punto si può fare affidamento su un algoritmo quando si tratta di salute e decisioni cliniche?

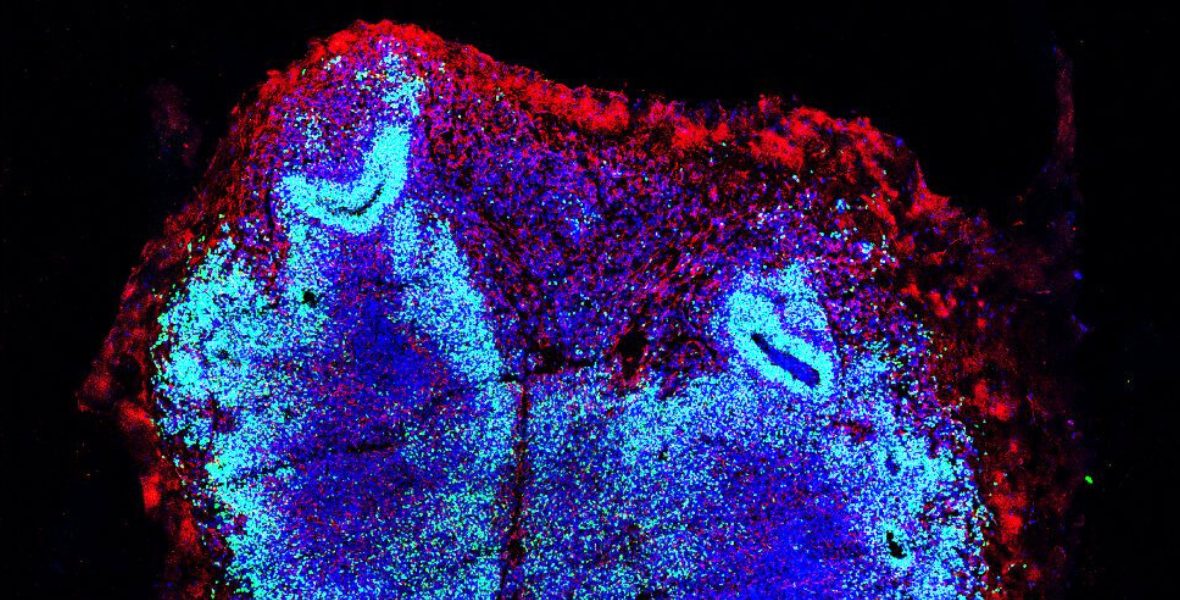

Un recente studio pubblicato sulla rivista Virchows Archiv, dal titolo “Unveiling the risks of ChatGPT in diagnostic surgical pathology”, ha cercato di rispondere a questa domanda analizzando in modo sistematico punti di forza e limiti di ChatGPT 3.5 in anatomia patologica, la branca della medicina che elabora diagnosi partendo dai tessuti umani: passaggio fondamentale per guidare il trattamento, soprattutto per le patologie neoplastiche.

Lo studio è stato guidato da Salvatore Lorenzo Renne, Professore Associato presso Humanitas University, e Silvia Uccella, Professore Ordinario, Direttrice della Scuola di Specializzazione in Anatomia Patologica di Humanitas University e Responsabile dell’Unità Operativa di Anatomia Patologica presso l’IRCCS Istituto Clinico Humanitas, e condotto da Vincenzo Guastafierro, specializzando in Anatomia Patologica presso lo stesso istituto. La pubblicazione è valsa l’assegnazione del Premio Anzalone, conferito il 18 ottobre dall’Ordine dei Medici Chirurghi e degli Odontoiatri della Provincia di Milano, al dott. Guastafierro.

Lo studio: come si è svolto

Gli autori hanno descritto 50 casi clinici istopatologici, coprendo dieci diversi ambiti di anatomia patologica fornendo, in ognuno, tutti gli elementi sufficienti per la diagnosi. Per ciascun caso, hanno chiesto a ChatGPT di proporre una diagnosi, come farebbe un patologo.

In particolare ogni scenario è stato presentato a ChatGPT in diverse modalità (chiedendo di vagliare alcune ipotesi diagnostiche proposte o chiedendo quali fossero le ipotesi più probabili, senza limitare il campo); inoltre ogni modalità è stata sottoposta con o senza la richiesta di fornire i riferimenti scientifici per giustificare la risposta. Le risposte sono state valutate da sei patologi esperti, che ne hanno giudicato utilità e accuratezza, annotando eventuali errori.

Nel complesso, ChatGPT ha fornito risposte ritenute utili in circa il 62% dei casi, dimostrando una buona capacità di comprendere il linguaggio tecnico e di costruire argomentazioni coerenti. Tuttavia, solo un terzo delle risposte è risultato completamente privo di errori, a conferma che il modello, pur competente sul piano linguistico, non garantisce ancora un’accuratezza diagnostica costante.

Per quanto riguarda le citazioni bibliografiche, circa il 70% era corretto, mentre una considerevole percentuale risultava imprecisa (12,1%) o addirittura inesistente (17,8%), secondo un fenomeno noto come hallucination.

Secondo gli autori questi risultati non rappresentano un fallimento, ma un punto di partenza per comprendere come integrare strumenti di IA nella pratica medica. ChatGPT mostra un potenziale interessante come supporto al ragionamento diagnostico, ma il suo utilizzo richiede supervisione esperta e consapevolezza dei limiti del modello.

Perché questi errori?

A differenza di un medico, un modello linguistico non “comprende” davvero ciò che elabora. ChatGPT genera testo sulla base di schemi linguistici e probabilità statistiche calcolate su grandi set di informazioni esistenti, non di conoscenze verificate nel merito o di un ragionamento causale. Spesso inoltre non distingue le fonti più aggiornate da quelle più obsolete.

Quando viene interrogato su casi complessi, come la distinzione tra due tumori simili, il modello tende a produrre risposte coerenti nella forma e nel contesto, ma talvolta inesatte nel contenuto. Analogamente, gli errori nelle bibliografie derivano dal fatto che il sistema può combinare nomi di riviste, autori e titoli in modo plausibile ma non reale.

Gli autori sottolineano che, sebbene ChatGPT mostri potenzialità, il suo impiego richiede cautela e non è ancora idoneo alla pratica diagnostica quotidiana, e suggeriscono che, in futuro, LLMs specializzati potrebbero fungere da assistenti di supporto in contesti complessi, come quello della diagnosi istologica. Inoltre, il notevole tasso di imprecisione rilevato nella generazione delle referenze bibliografiche indica la necessità di cautela nel suo utilizzo come strumento di apprendimento da parte degli studenti.

In conclusione, i risultati confermano che ChatGPT non è ancora in grado di sostituire il giudizio umano nell’ambito della diagnosi istopatologica, evidenziando il ruolo imprescindibile del patologo. La responsabilità ultima della diagnosi rimane saldamente nelle mani del professionista umano.

Uno strumento, non un sostituto

L’articolo evidenzia un concetto chiave: l’IA, per quanto sofisticata, non può sostituire lo studio, il ragionamento e il giudizio di un medico. L’anatomia patologica non si limita all’analisi testuale, ma richiede anche l’interpretazione visiva dei campioni, l’integrazione dei dati clinici e il confronto con il team sanitario, tutti aspetti che richiedono il contributo fondamentale del patologo.

La vera sfida non è sostituire l’essere umano, ma costruire una collaborazione sicura e trasparente tra uomo e macchina. Solo così la tecnologia può diventare un alleato affidabile della medicina, e non un rischio nascosto dietro un linguaggio perfettamente formulato.